Неуронске мреже подржане физичким законима

Неуронска мрежа поткрепљена физичким законима (у даљем тексту НМПФЗ) је техника машинског учења која може се користити за апроксимацију решења парцијалне диференцијалне једначине. Парцијалне диференцијалне једначине са одговарајућим почетним и граничним условима могу се изразити у општем облику као:

Овде је \(\mathcal{N}\) диференцијални оператор, \(X \in {\Omega \subseteq R}^{d}\) и \(t \in R\) представљају просторне и временске координате, респективно, док је \(\Omega \subseteq R\) целокупни домен проблема. \(\Omega_{g} \subseteq \Omega\) представља рачунски домен граничних услова, \(u(X,t)\) је решење парцијалне диференцијалне једначине са почетним условом \(h(X)\) и граничним условом \(g(X,t)\). Оваква формулација се такође може применити и на парцијалне диференцијалне једначине вишег реда, пошто се једначине вишег реда могу написати и у облику система једначина првог реда.

У оригиналној формулацији Raissi et al. [RPK19], НМПФЗ се састоји од две подмреже:

апроксиматор мреже и

резидуалне мреже.

Апроксиматор мрежа прима улаз \((X,t)\), пролази кроз процес обуке и као излаз даје приближно решење \(\widehat{u}(X,t)\) парцијалне диференцијалне једначине. Мрежа апроксиматора се тренира на мрежи тачака, тзв. колокационих тачака, узоркованих из домена проблема. Тежине и пристрасности (енг. bias) апроксиматор мреже су параметри који се могу тренирати минимизирањем композитне функције губитка у следећем облику:

где су

Овде, \(\mathcal{L}_{r}\), \(\mathcal{L}_{0}\) и \(\mathcal{L}_{b}\) представљају резидуале основне диференцијалне једначине, почетних и граничних услова, респективно. Поред тога, \(N_{r}\), \(N_{0}\) и \(N_{b}\) су бројеви колокационих тачака домена проблема, домена почетних и граничних услова, респективно. Ови резидуали се израчунавају компонентом НМПФЗ модела који се не обучава, а зове се резидуална мрежа. Да би се израчунао губитак \(\mathcal{L}_{r}\), НМПФЗ захтева изводе излаза у односу на улазе. Тај рачун се постиже тзв. аутоматском диференцијацијом.

Аутоматска диференцијација је кључни покретач развоја НМПФЗ-а и кључни је елемент који разликује НМПФЗ од сличних настојања 90-их година прошлог века. На пример, Psichogios and Ungar [PU92] и Lagaris et al. [LLF98] су се ослањали на мануелно извођење правила пропагације уназад. Данас се рачуна на аутоматску диференцијацију која је имплементирана у већини оквира за дубоко учење, као што су Tensorflow и PyTorch. На овај начин избегавамо нумеричку дискретизацију током рачунања извода свих редова у простор-времену.

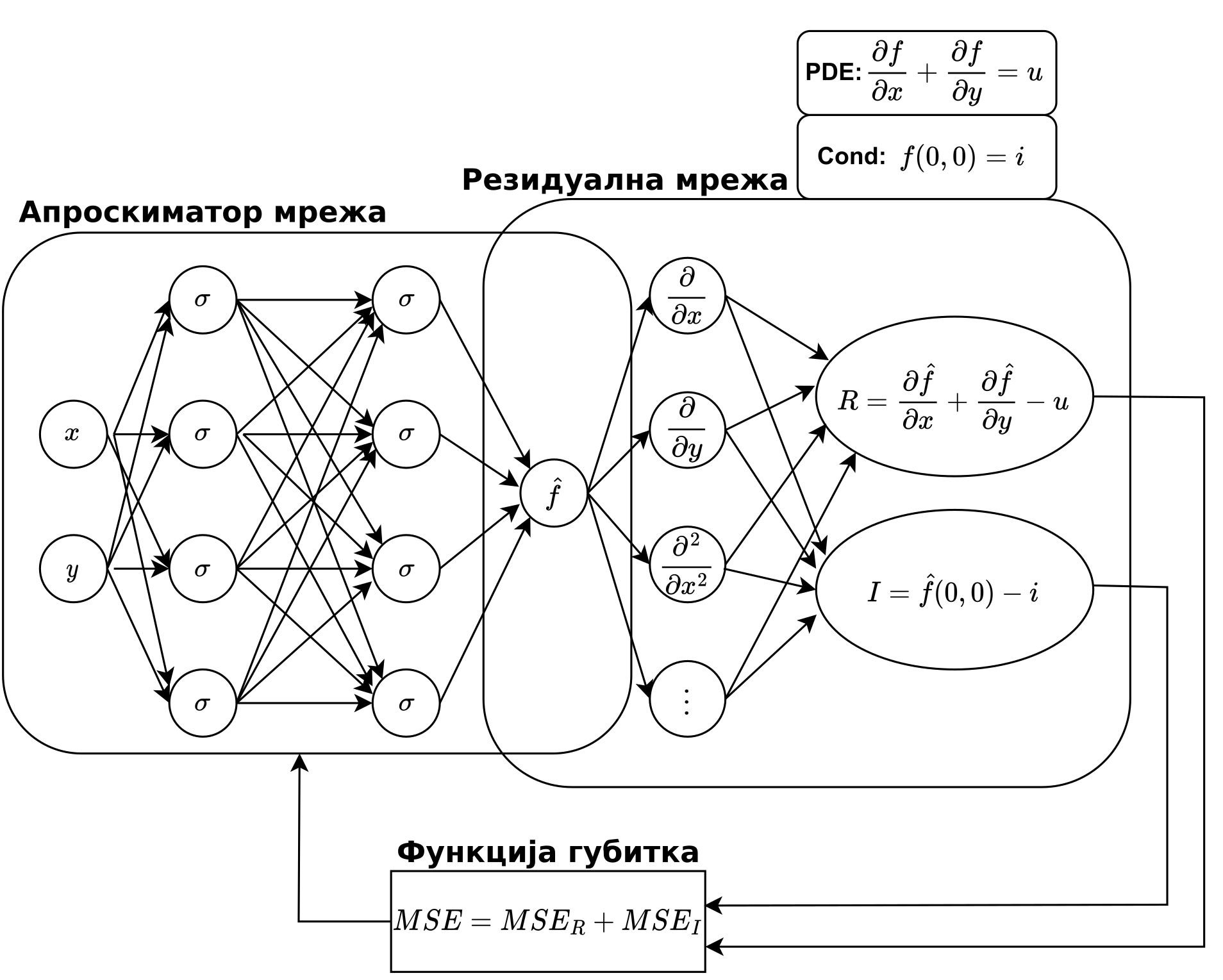

Шема типичног НМПФЗ-а је приказана на Сл. 1 на којој је једноставна парцијална диференцијална једначина \(\frac{\partial f}{\partial x} + \frac{\partial f}{\partial y} = 0\) искоришћена као пример. Као што је приказано, мрежа апроксиматора се користи за апроксимацију решења \(u(X,t)\), које затим иде на резидуалну мрежу за израчунавање функције губитка диференцијалне једначине \(\mathcal{L}_{r}\), губитка граничних услова \(\mathcal{L}_{b}\), и губитка почетних услова \(\mathcal{L}_{0}\). Тежине и пристрасности апроксиматорске мреже обучени су коришћењем прилагођене функције губитка која се састоји од резидуала \(\mathcal{L}_{r}\), \(\mathcal{L}_{0}\), и \(\mathcal{L}_{b}\) кроз технику градијента спуштања засновану на пропагацији уназад.

Сл. 1 Архитектура НМПФЗ-а и стандардна петља за обуку НМПФЗ-а конструисана за решавање једноставне парцијалне диференцијалне једначине, где PDE и Cons означавају једначине, док R и I представљају њихове резидуале. Мрежа апроксиматора је подвргнута процесу обуке и даје приближно решење. Резидуална мрежа је део НМПФЗ-а који се не обучава и који је способан да израчуна изводе излаза апроксиматорске мреже у односу на улазе, што резултира композитном функцијом губитка, означеном са MSE.

У наредној секцији Пример конструкције функције губитка описаћемо како би изгледала конструкција композитне функције губитка за логистичку једначину.